Pouvons-nous faire confiance à une vidéo après aujourd’hui? …

Internet est rempli de contenu « DeepFakes » – qu’il s’agisse d’un son, de photos ou de vidéos réalisées à l’aide d’outils d’intelligence artificielle – où les gens semblent qu’ils disent ou ne faisaient pas de choses qu’ils ne disaient pas ou ne faisaient pas, ou ils sont dans des endroits où ils ne l’étaient pas, ou leurs changements d’apparence.

Certains incluent ce qui est connu sous le nom de «nudité numérique», car les images sont modifiées pour montrer à quelqu’un sans vêtements. Une autre «contrefaçon profonde» est utilisée pour tromper les consommateurs ou nuire à la réputation des politiciens et d’autres personnalités publiques.

L’intelligence artificielle est facile à créer une « contrefaçon profonde » en seulement quelques clics sur le clavier. Les gouvernements sont impatients de faire face à ce phénomène, mais la bataille semble perdre, car les tentatives d’utiliser des « contrefaçons profondes » ont augmenté de plus de 20 fois au cours des trois dernières années, selon les données de la société d’identité « Signicat ».

Quelles mesures prises pour lutter contre la « contrefaçon profonde »?

Le 19 mai, le président américain Donald Trump a signé la loi « Take It Download », qui criminalise les documents pornographiques non consensuels utilisant l’intelligence artificielle, également connue sous le nom de « vengeance pornographique », et oblige les sociétés de médias sociaux à supprimer ces images sexuelles explicites sur demande.

L’année dernière, le comité fédéral des communications américaines a fait l’utilisation de voix d’intelligence artificielle dans les appels automatiques illégaux.

Cette interdiction est survenue deux jours après que le comité a publié un « arrêt et un arrêt » contre la société responsable de la « contrefaçon audio profonde » par le président Joe Biden. Les résidents de New Hamposher avaient reçu un appel automatique avant les élections préliminaires présidentielles dans l’État, dans lesquelles la voix semblait être une voix de Biden, les exhortant à rester chez elle et « garder leurs votes pour les élections de novembre ».

Le droit de l’IA de l’Union européenne oblige les plates-formes à mettre des signes que le contenu est le produit de « Fonde Fovegle ». La Chine a appliqué une législation similaire en 2023. Le 28 avril, le commissaire des affaires pour enfants du gouvernement britannique a appelé en ligne à une grande « nudité numérique ».

Où a été rapporté « Deep Counterfaiting » dans l’actualité?

Des photos de «contrefaçon profonde» se sont propagées à la pop star, Taylor Swift, largement sur les réseaux sociaux en janvier 2024, a mis en colère ses fans et poussé la Maison Blanche à exprimer sa préoccupation.

Lors des élections présidentielles américaines en 2024, Elon Musk a partagé une vidéo de propagande en utilisant « une contrefaçon profonde » dans laquelle une voix modifiée utilisant l’intelligence artificielle du candidat démocrate, Kamala Harris, sans que la vidéo ne soit classée comme trompeuse.

Dans la vidéo, elle a semblé décrire le président, Joe Biden, comme « la différence » et dit qu’elle ne « sait rien de la gestion du pays ». La vidéo a remporté des dizaines de millions de vues. En réponse, le gouverneur de Californie, Gavin Newsum, s’est engagé à interdire la «contrefaçon profonde» modifiée numériquement, et a été légalement signé en septembre.

Comment faire des vidéos en utilisant « une contrefaçon profonde »?

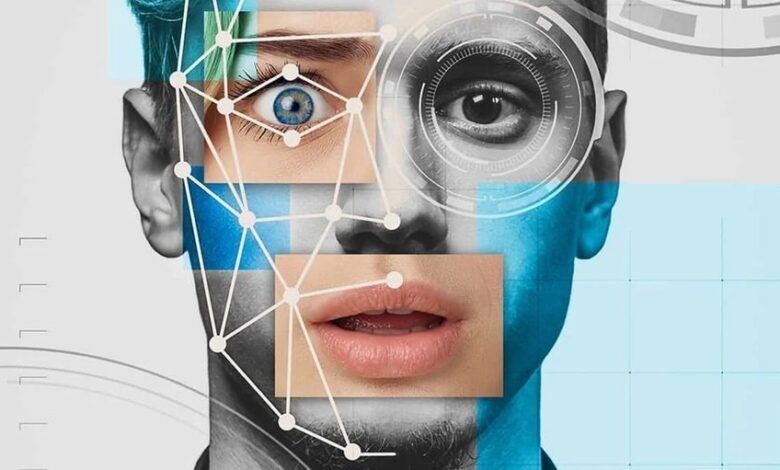

Il est souvent produit à l’aide d’un algorithme d’intelligence artificielle formé pour identifier les modèles dans de vrais enregistrements vidéo d’une personne spécifique, un processus appelé « apprentissage profond ».

Ensuite, il devient possible de remplacer un élément d’une vidéo, comme le visage de la personne, par un autre contenu sans qu’il apparaisse comme un montage superficiel. Ces modifications sont plus trompeuses lorsqu’ils les utilisent avec des techniques de « clonage sonore », qui analysent un clip audio d’une personne qui parle de très petites pièces audio qui sont réassemblées pour former de nouveaux mots qui semblent être le haut-parleur vidéo original.

Comment la «contrefaçon profonde» s’est-elle propagée?

Cette technologie était initialement la réserve des universitaires et des chercheurs. Cependant, en 2017, la plate-forme « Motherboard » du site Web « Vice » a rapporté qu’un Reddit appelé « Deep Fix » avait créé un algorithme pour faire de fausses vidéos en utilisant une lame open source. « Reddit » a interdit cet utilisateur, mais la pratique s’est rapidement propagée. À ses débuts, une technologie de contrefaçon profonde nécessitait une véritable vidéo et des performances audio réelles, ainsi que des compétences de montage avancées.

Aujourd’hui, les systèmes d’intelligence obstétricale actuels permettent aux utilisateurs de produire des images et des vidéos convaincantes via des commandes écrites simples. Demandez à un ordinateur de créer une vidéo qui met des mots dans la bouche d’une personne, et cela vous verra certainement.

Comment pouvez-vous apprendre à connaître la « contrefaçon profonde »?

Ces contrefaçons numériques sont devenues plus difficiles à découvrir, avec des sociétés d’intelligence artificielle utilisant de nouveaux outils sur une énorme quantité de matériel disponible sur Internet, de YouTube aux bibliothèques photo et vidéo stockées.

Parfois, des signes clairs indiquent qu’une image ou une vidéo de ce qui a été créé en utilisant l’intelligence artificielle, comme avoir une fête non place ou une main contenant six doigts. La différence de couleurs peut apparaître entre les parties modifiées et modifiées de l’image.

Parfois, le mouvement de la bouche ne correspond pas au discours dans les clips de la « contrefaçon profonde ». L’intelligence artificielle peut avoir du mal à fournir des détails précis d’éléments tels que les cheveux, la bouche et les ombres, et les bords des corps peuvent parfois être rugueux ou contenir des pixels visibles.

Mais tout cela peut changer avec l’amélioration des modèles de base.

Quels sont les exemples les plus importants de l’utilisation de la technologie de «contrefaçon profonde»?

En août 2023, des promoteurs chinois ont publié des photos modifiées d’incendies de forêt sur l’île Maui à Hawaï, pour soutenir les allégations selon lesquelles ces incendies sont causés par un test d’armes « aérien » secret des États-Unis.

En mai 2023, les actions américaines ont chuté peu de temps après une image sur Internet montrant le Pentagone comme s’il brûlait. Les experts ont déclaré que la fausse image comporte des caractéristiques de production en utilisant l’intelligence artificielle.

En février de la même année, un faux clip audio est apparu dans lequel il semblait que le candidat à la présidentielle nigériane, Atiko Abu Bakr, prévoyait de falsifier les élections de ce mois-ci.

En 2021, un clip vidéo unique a été publié sur les réseaux sociaux, montrant le président ukrainien Voludmir Zellinski, comme s’il appelait ses soldats à jeter les armes et à se rendre à la Russie. Il existe d’autres formes «profondes» nuisibles, comme celles qui montrent la star du football Cristiano Ronaldo alors qu’il chante des poèmes arabes.

Quelles sont les dimensions dangereuses associées à cette technologie?

La peur réside dans les clips de « contrefaçon profonds » pour devenir si convaincants de rendre impossible la distinction entre ce qui est réel et ce qui est faux. Imaginez des fraudeurs manipulant les cours des actions en produisant des vidéos forgées de dirigeants qui font des mises à jour liées à leurs entreprises, ou de faux clips de soldats qui commettent des crimes de guerre.

Les politiciens, les chefs d’entreprise et les célébrités sont parmi les plus vulnérables, étant donné le grand nombre d’enregistrements disponibles pour eux.

La technique de «contrefaçon profonde» fournit également ce que l’on appelle la «vengeance porno» même en l’absence de toute image ou vidéo réelle de la personne et elle est nue, et les femmes sont souvent ciblées. Une fois que la vidéo s’est répandue sur Internet, il devient presque impossible de le contenir.

Le rapport du commissaire aux affaires pour enfants du Royaume-Uni publié en avril a souligné l’augmentation de la crainte des enfants d’être victimes d’un contenu scandaleux « de contrefaçon » profond « .

Des préoccupations supplémentaires faciliteront la propagation de la sensibilisation à la « contrefaçon profonde » de la revendication des personnes qui apparaissent réellement dans des dossiers et qu’ils disent ou ont rejeté ou rejeté ou illégal, que les preuves contre eux sont fausses, car certaines personnes ont déjà commencé à utiliser la défense « de contrefaçon » profonde « avant les tribunaux.

Quelles autres mesures peuvent être prises pour réduire la propagation de la «contrefaçon profonde»?

Il est impossible d’inverser le type d’apprentissage automatique utilisé dans la production de « contrefaçon profonde » afin de découvrir de faux clips. Mais un petit nombre de startups telles que Sensity IA aux Pays-Bas et « Sentinel » en Estonie s’efforcent de développer des techniques pour détecter les faux clips, ainsi que de nombreuses grandes sociétés technologiques aux États-Unis.

Les entreprises, dont Microsoft, se sont engagées à inclure des filigranes numériques dans les images qu’elles produisent en utilisant leurs outils d’intelligence artificielle, pour les distinguer comme un faux contenu. Openai, la société, a également développé des techniques de détection des images produites avec l’intelligence artificielle, ainsi qu’un moyen d’ajouter des filigranes aux textes, mais la dernière technologie n’a pas encore été présentée, en partie parce qu’elle voit qu’il est facile pour les mauvaises parties de les contourner, selon le site Web de Bloomberg.